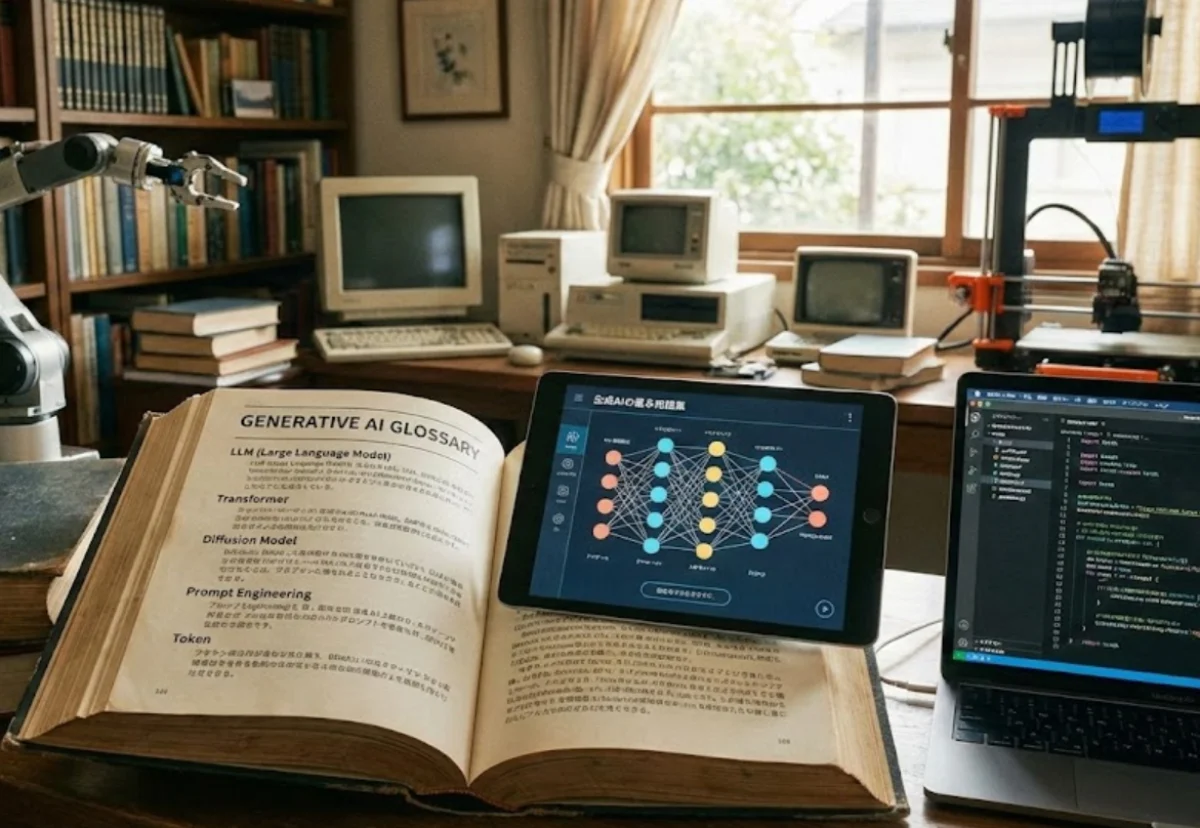

生成AIは、入力された文章や画像などを手がかりに、次に来そうな情報を計算して文章や画像を作る仕組みです。

ところが専門用語が多く、全体像がつかめません。

そこで本記事では、まず超基礎の言葉から入り、次にAIが何を材料にして考え、どう出力し、外の道具とつながり、安全に運用されるのかまでを解説しています。

最初に押さえる超基礎用語

ここが分かると、以降の用語が理解できます。

まずはAIの中身を細かく見る前に、全体を動かすための基本語をそろえます。

- 生成AI 文章や画像などを新しく作るAIの総称です。

- LLM 大量の文章で学び、文章を作るのが得意なAIのことです。

- モデル 学習の結果としてできたAIの本体で、重みが詰まった設計図のようなものです。

- 学習 例題を大量に見て、うまく当てるコツを体の中に作ることです。

- 推論 学習済みのモデルを使って、実際に答えを作る計算のことです。

- トークン AIが文章を数えるときの単位で、文字や単語のかたまりです。

- コンテキスト AIが今見えている情報の範囲で、会話の履歴や資料も含みます。

- ハルシネーション それっぽいが事実ではない内容を自信ありげに作ってしまう現象です。

- ツール連携 AIが外部の検索や計算や社内システムを使えるようにすることです。

- 評価 出力が目的に合っているかをテストし、改善につなげることです。

豆知識 LLMは文章をそのまま理解しているというより、次に来るトークンを当てるゲームを超大量に練習している、と考えると全体像がつかみやすいです。

入力の単位 トークンとコンテキストウィンドウ

トークンは、AIが文章を計算するときの最小単位です。人間は文字や単語で読みますが、AIは文章を細かいかたまりに分けて数えます。だから、同じ長さの文章でも言語や書き方でトークン数が変わります。

コンテキストウィンドウは、AIが一度に見渡せるトークンの上限です。会話の履歴、貼り付けた資料、指示文などが合計でここに収まる必要があります。収まらないと、古い情報が見えなくなったり、要約されて細部が落ちたりします。

AIが文章を作る仕組み 推論と生成

ここで言う推論は、学校の推論とは少し違い、学習済みモデルが計算して出力を作る工程を指します。入力されたトークン列から、次に来るトークンの候補を確率で並べ、選びながら文章を伸ばしていきます。これが生成です。

生成には調整つまみがあり、代表が温度です。温度を上げると発想が散りやすくなり、下げると堅く安定しやすい傾向になります。もう一つよく使うのがtop-pで、確率の高い候補の中から選ぶ範囲を決めます。これらは正解を保証するものではなく、出力の性格を変える設定です。

マルチモーダルは、文章だけでなく画像や音声など複数の種類の入力を扱えることです。マルチモーダル生成は、画像を見て説明文を作る、逆に文章から画像を作る、といった複数形式の生成を指します。

間違いの正体 ハルシネーションが起きる理由

ハルシネーションは、AIがうそをつく意思を持っているからではありません。AIは基本的に、もっともらしい続き方を優先して文章を作ります。だから、入力に事実の裏付けが不足していたり、質問があいまいだったり、参照すべき資料が与えられていないと、もっともらしいが不正確な内容が混ざります。

対策の基本は二つです。第一に、根拠となる資料をAIに見せることです。第二に、出力の形式と条件を具体的に決め、検証しやすくすることです。

文脈の与え方 プロンプトとRAG

プロンプトはAIへの指示文です。プロンプトエンジニアリングは、AIが誤解しない形に指示を設計する工夫です。例えば、目的、前提、禁止事項、出力形式、判断基準を分けて書くとブレが減ります。

RAGは検索拡張生成と呼ばれ、AIが外部の資料を探してから答えを作るやり方です。モデルの頭の中だけに頼らず、必要な情報を取りに行って文章を作るので、最新情報や社内資料に強くなります。RAGは研究としても定着しており、学習済みモデルと検索用の外部メモリを組み合わせる考え方として整理されています。

RAGでよく出る用語が埋め込みとベクトル検索です。埋め込みは、文章の意味を数の並びに変換したものです。ベクトル検索は、その数の並び同士の近さを使って、意味が近い文章を探す方法です。これにより、キーワードが一致しなくても、内容が近い資料を拾いやすくなります。

豆知識 RAGは万能ではありません。元の資料が古い、間違っている、矛盾している場合は、そのまま間違いを増幅します。資料の品質管理が効きます。

AIコアの中身 LLMの性能を決める要素

ここからが、いわゆるAIの中核です。ただし難しく見えても、性能を左右するポイントは限られます。

パラメータ数は、モデル内部の調整つまみの総数です。一般に多いほど表現力が増えやすい一方、計算資源も必要になります。パラメータが多いから必ず賢い、ではなく、学習データや設計や使い方も効きます。

Transformerは、現在のLLMの中心となる設計で、文章中のどの単語同士が関係しているかを見ながら処理します。その中核が注意機構で、重要な部分に重みを置いて読む仕組みです。

レイテンシは応答までの待ち時間です。速さは体感の使いやすさに直結します。速度はモデルの大きさだけでなく、サーバーの性能や同時利用の混雑、そして後述する最適化で変わります。

学習の種類 事前学習と調整と蒸留

事前学習は、大量の文章やコードを広く学んで基礎体力を作る工程です。ここで一般知識や言語のクセを身につけます。

ファインチューニングは、目的に合わせて追加学習して得意分野を作る工程です。例えば社内用語の言い回し、特定の文体、決まった出力形式などを安定させます。近い言い方としてSFTがあり、正解例を見せて調整する方式を指すことが多いです。

RLHFは、人間の好みや安全基準に沿うように、良い回答を高く評価して調整する考え方です。仕組みは複雑ですが、狙いは暴走しにくくすることです。

蒸留は、大きいモデルの振る舞いを手本にして、小さいモデルに知識や出力の癖を移す方法です。軽くして動かしやすくするために使われます。

量子化は、モデルの数値を粗くして容量や計算を軽くする最適化です。軽くなる代わりに精度が落ちる場合もあるので、用途に合わせて選びます。

外部とつなぐ ツール呼び出しとMCPとオーケストレーション

AIを便利にする本丸は、AI単体ではなく、外部の道具とつなげることです。代表がFunction CallingまたはTool Callingで、AIが決められた形式で外部機能を呼び出し、結果を受け取って回答に反映します。例えば検索、計算、予約、社内データ参照などがここに入ります。

MCPは、AIアプリと外部システムをつなぐための共通規格として提案されたオープンなプロトコルです。個別に連携を作り込む手間を減らし、同じやり方で複数の道具やデータ源につながることを狙います。

オーケストレーションは、複数のモデルやツールを順番に動かし、全体を一つの仕事として成立させる設計です。例えば、検索して、要約して、表にして、最後に文章を整える、のように段取りを組みます。

AIエージェントは、目的を与えると、必要な手順を考えながらツールを使い、ある程度自動でタスクを進める仕組みです。ただし万能ではなく、権限設計と失敗時の止め方が重要です。

開発の現場 ローコードとバイブコーディング

ローコードやノーコードは、画面上で部品を組み合わせてアプリを作る考え方です。AI機能も部品化が進み、試作が速くなりました。

バイブコーディングは、細かい設計より先に、AIにコードを書かせて動くものを作り、動きながら直す開発スタイルを指す言い方です。速い反面、仕様があいまいなまま肥大化しやすいので、途中で要件とテストを固めないと破綻します。

セーフティ 攻撃と防御の基本

プロンプトインジェクションは、悪意ある文章を混ぜて、AIに本来の指示を無視させたり、隠した情報を引き出させたりする攻撃です。脱獄は、禁止されている振る舞いをさせようとする誘導全般を指すことが多いです。

ガードレールは、防御の仕組みの総称です。入力の検査、出力の検査、ツール実行の前の許可、危険な操作のブロック、ログ監査などを組み合わせます。特にエージェント型は外部操作が絡むため、権限を最小にし、実行前に確認を挟む設計が基本になります。

- 原則1 AIに渡す社内データは最小限に絞ることです。

- 原則2 外部ツール実行には段階的な許可と制限を置くことです。

- 原則3 失敗したときに被害が出ない戻し方を用意することです。

品質改善と運用 評価とLLMOps

評価は、出力が正しいか、役に立つか、安全か、を測る仕組みです。人が読む評価だけでなく、テスト問題を自動で回して劣化を検知する方法もあります。

LLMOpsは、LLMを業務で安定運用するための考え方で、評価、監視、改善、再学習、コスト管理などを含みます。作って終わりではなく、品質と安全と性能を維持するための運用を体系化する領域です。

ここで重要な追加用語がモニタリングです。ハルシネーション率の増加、応答遅延の悪化、特定の質問で失敗が増える、といった変化を早めに検知します。もう一つがドリフトで、環境やデータが変わり、昔はうまくいったやり方が効かなくなる現象です。

この順番で覚えると早く覚えられる

生成AIは、入力の単位と見える範囲を理解し、推論としての生成を押さえ、間違いの性質を知り、文脈付与としてRAGを理解し、次にモデルの中身と学習を知り、外部ツール連携とエージェントで実用化し、セーフティと評価とLLMOpsで現場品質に落とす、という順序で流れを理解し覚えることができます。

コメント